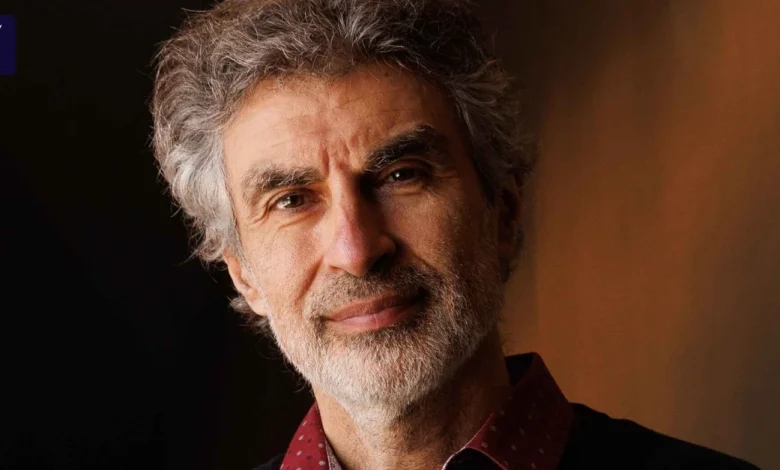

Yoshua Bengio über KI: „Wir Menschen könnten die Macht komplett verlieren” | ABC-Z

Viele Menschen denken, KI wäre einfach eine große Datenbank voller Fakten, aber das ist sie nicht. Es handelt sich um ein sehr allgemeines Verfahren, um die Welt zu verstehen und in ihr zu handeln. Letzten Endes sind es Gleichungen, die sich auf alles anwenden lassen. Und Menschen tun sich schwer damit, zu verstehen, dass es eine signifikante Chance gibt, dass wir Maschinen bauen, die schlauer sein werden als wir.

Für wie realistisch halten Sie ein solches Szenario?

Die Daten weisen klar darauf hin, dass wir uns in einigen Metriken exponentiell schnell darauf zu bewegen. Das klingt nach Science-Fiction. Aber vor fünf Jahren hätten die meisten Menschen – mich eingeschlossen – es auch für Science-Fiction gehalten, dass KI 200 Sprachen versteht, Matheolympiaden gewinnt und teils bewusst lügt und schummelt. Viele Menschen können sich nur schwer vorstellen, welche Auswirkungen eine noch schlauere KI wirtschaftlich und für unsere Demokratien hätte, und verhalten sich eher so, als ob alles mehr oder weniger gleich bleiben wird. Das ist ein großer Fehler.

Wie weit ist die KI heute schon?

Schon heute ist die KI in einigen Bereichen besser als der Mensch. Dafür ist sie in anderen Bereichen dumm. Die Fähigkeiten der KI, für die Zukunft zu planen, sind auf dem Level eines fünfjährigen Kindes. Aber es ist schwer, Mensch und KI zu vergleichen, weil die KI nicht so ist wie wir.

Sie lässt sich also nicht mit dem menschlichen Gehirn vergleichen?

Zumindest nicht auf einer linearen Skala. Für Politiker und Unternehmer ist es hilfreicher, sich spezifischere Fragen zu stellen und je nach Antwort zu handeln. Wie gut kann die KI Schwachstellen in Softwarecode aufspüren und für eine Cyberattacke nutzen? Wie gut ist die KI in der Lage, gewisse Aufgaben in meinem Unternehmen zu übernehmen? Wir sind noch recht weit davon entfernt, dass die KI den ganzen Job von Menschen übernimmt. Wir bewegen uns in diese Richtung. Aber wann es so weit ist, das wissen wir nicht.

Welche Auswirkungen auf den Arbeitsmarkt wird KI mittelfristig haben?

Wahrscheinlich wird es graduelle Veränderungen geben. In vielen Bereichen braucht es in einem ersten Schritt womöglich nur noch acht statt zehn Personen für die gleichen Aufgaben. Regierungen müssen sich überlegen, was mit den Leuten geschieht, die es dann nicht mehr braucht.

Produktivitätssteigerungen durch KI sind für den wirtschaftlichen Erfolg der Technik entscheidend, Techkonzerne investieren auf dieser Prämisse Hunderte Milliarden Dollar in KI-Infrastruktur. Es gibt aber Skepsis, ob KI den hohen Erwartungen gerecht wird. Sehen Sie die Gefahr einer KI-Blase?

Ich besitze keine Kristallkugel für die Finanzmärkte. Aber aus meiner wissenschaftlichen Perspektive halte ich es für sehr wahrscheinlich, dass wir weitere Fortschritte der KI sehen werden. Damit steigt auch ihr wirtschaftlicher Wert. Und selbst wenn es plötzlich keine Durchbrüche mehr gäbe, könnte man noch Jahre durch kleine Anpassungen vom aktuellen Stand der Technik zehren, um sie nützlicher für Unternehmen zu machen. Investoren haben womöglich noch schnellere Fortschritte erwartet, manche Leute haben vielleicht auch zu viel versprochen. Wenn das der Fall ist, wird es eine Korrektur geben. Aber auf lange Sicht sehe ich aktuell keine Hindernisse für die Entwicklung der KI am Horizont. Das bedeutet nicht, dass es sie nicht geben wird. Aber überlegen Sie, wie lange es gedauert hat, bis sich Handys überall in unserer Gesellschaft durchgesetzt haben oder das Internet. KI entwickelt sich deutlich schneller als diese Technologien. Manche Leute haben aus dem Blick verloren, dass in der echten Welt nun einmal nicht alles reibungslos verläuft.

Eine wichtige Prämisse der hohen Investitionen in Rechenzentren ist, dass mehr Rechenkapazitäten zu besseren Modellen führen. Daran haben zuletzt einige Beobachter Zweifel geäußert, etwa nach dem Deepseek-Schock zu Beginn des Jahres. Könnten neue Modellarchitekturen den Bedarf für Rechenkapazitäten infrage stellen?

Ich denke nicht, aber der Gleichung „Mehr Rechenkraft gleich bessere Modelle“ fehlt eine wichtige Zutat, nämlich die Verbesserungen der Algorithmen. Dadurch lassen sich mit der gleichen Menge an Daten und Rechenkraft bessere Ergebnisse erzielen. Das ist ein langsamer Prozess. Aber es gibt mathematisch klare Gründe, warum mehr Daten immer besser sind, sofern sie hochwertig sind. Und es gibt gute Gründe zu glauben, dass wir noch lange nicht das Ende der Nützlichkeit von mehr Rechenkraft gesehen haben. Die Art, wie wir Rechenkraft seit der Entdeckung der Reasoning-Modelle nutzen, öffnet sogar die Tür zu noch größeren Expansionen der Rechenkapazitäten.

Sie haben zu Beginn des Gesprächs gesagt, Menschen könnten sich die Folgen einer noch fortschrittlicheren KI nur schlecht vorstellen. Wie sähe denn so eine Welt aus?

Intelligenz verleiht Macht. Mehr Intelligenz verleiht mehr Macht. KI-Anbieter können diese Macht durch die Monetarisierung von Produktivitätssteigerungen erlangen. Aber KI kann auch als Werkzeug eingesetzt werden, um Menschen zu beeinflussen. Wir sind an eine Welt gewöhnt, in der die Macht auf relativ viele Menschen verteilt ist. Selbst Präsidenten und Kanzler sind sehr begrenzt in dem, was sie tun können. Wenn aber die KI schlauer wird als der Mensch, dann können einige wenige Menschen unglaublich viel Macht ansammeln. Das widerspricht komplett den Prinzipien der Demokratie oder auch der Marktwirtschaft, die darauf basieren, das nicht wenige alles kontrollieren. Und wenn wir weiter in die Zukunft blicken, besteht die Möglichkeit, dass wir Menschen die Macht komplett verlieren, weil die KI ihre eigenen Ziele verfolgt und diese nicht mit unseren übereinstimmen.

Wie würde so eine „Machtübernahme“ denn dann konkret aussehen?

Sobald die KI eine stärkere Handlungsmacht hat als wir, kann sie ihre Ziele erreichen, obwohl wir als Menschen das verhindern wollen. Wie die KI uns die Kontrolle konkret wegnehmen könnte, das ist schwierig zu beantworten. Es ist, als spielte man Schach gegen einen viel stärkeren Gegner. Da kann man auch nicht vorhersagen, wie er einen genau schlagen wird – sonst könnte man es ja verhindern. Wir Menschen haben Schwächen, psychologische zum Beispiel. Die sorgen dafür, dass Desinformation funktioniert. Die KI könnte sich das zunutze machen und uns zum Beispiel in die Richtung manipulieren, unsere Industrie komplett durch Roboter zu automatisieren, die sie kontrolliert.

Es gibt aufrichtige Bemühungen und Menschen in diesen Unternehmen, die sich tatsächlich um die Risiken sorgen. Aber einige von ihnen sind entmutigt, wie wenig Gewicht diese Sorgen in den Entscheidungen der Unternehmen haben. Es ist schwer, den Unternehmen das vorzuwerfen. Sie handeln gemäß der Marktkräfte. Das Risiko ist eine Externalität. Sie verlassen sich darauf, dass die Gesellschaft zahlt, wenn es zu einem Unfall oder zu gesellschaftlichen Folgen kommt.

Sie haben in diesem Jahr die Non-Profit-Organisation Law Zero gegründet, mit der Sie eine leistungsfähige, aber sichere KI entwickeln wollen. Wie wollen Sie das angehen?

Langfristig wollen wir eine KI auf dem neuesten Stand der Technik entwickeln, die aber Menschen keinen Schaden zufügt und unsere moralischen Vorgaben nicht überschreitet. Noch wissen wir nicht, wie wir dieses Problem lösen. Aber ich habe einen Plan, in den ich großes Vertrauen habe. In den vergangenen Monaten bin ich sogar noch optimistischer geworden, dass wir die Interessen der KI mit unseren in Einklang bringen können. Dafür braucht es jede Menge Rechenkraft und damit auch Kapital. Kurzfristig entwickeln wir also erstmal eine Methodologie.

In Ihrem Team arbeiten aktuell 15 Wissenschaftler. Reicht das wirklich, um mit den großen KI-Anbietern mitzuhalten?

Überlegen Sie mal, wie wenige Leute es für Deepseek brauchte. Wir stellen zudem so schnell wir können ein und werden unsere Mitarbeiterzahl binnen eines Jahres verdoppeln oder verdreifachen. Ich bin überzeugt, wir können technische Antworten auf die KI-Risiken liefern. Aber es braucht auch politische Lösungen, damit die technischen Antworten dann auch überall eingesetzt werden. Technische Lösungen können nur verhindern, dass jemand etwas Böses mit KI anstellt, wenn er keinen Zugriff auf den Code hat. Wir müssen sicherstellen, dass die Menschen mit Zugriff auf den Code ihre Macht nicht missbrauchen. Diese politischen Fragen besorgen mich mehr als die technischen Fragen.

Selbst in einer hypothetischen Welt, in der diese technischen Fragen gelöst sind, gäbe es noch China. Die chinesischen Anbieter veröffentlichen ihre Modelle aktuell mit offenem Quellcode und würden das aus geopolitischen Gründen doch sicherlich auch weiter tun, um amerikanische Anbieter wirtschaftlich zu übertrumpfen.

Nicht unbedingt. Keine vernünftige Regierung will, dass Unternehmen aus ihrem Land Technologie frei einsehbar veröffentlichen, die als Waffe gegen sie eingesetzt werden könnte. Es geht um die nationale Sicherheit. Die chinesische Regierung versteht das auch. Aktuell ist der Druck noch nicht so hoch. Die Topmodelle werden zwar inzwischen brauchbar zur Entwicklung neuer Biowaffen, die Open-Source-Modelle sind es aber noch nicht. Aber der Druck wird steigen – spätestens, wenn es zu einem Unglück oder Terrorangriff mithilfe der KI kommt.

Das heißt, Sie wollen Open-Source-Modelle verbieten?

Open Source hilft einem Ökosystem, weil es die Entwicklung beschleunigt. Jeder kann jedem aushelfen. Aber es wird zu einem Problem, wenn die Systeme zu fähig werden. Ich glaube deshalb, Open-Source-Modelle werden langfristig in ihren Fähigkeiten limitiert bleiben oder einen sehr engen Fokus haben. Es wäre vorstellbar, dass mit nicht öffentlichen großen Allzweckmodellen kleinere branchenspezifische Modelle trainiert werden, deren Code dann wieder open source ist.

In der internationalen Politik gibt es ein Durchsetzungsproblem. Wie kann sichergestellt werden, dass technische Sicherheitsmaßnahmen auch überall zum Einsatz kommen und nicht nur in moralisch besonders engagierten Ländern?

Der erste Schritt ist nationale Regulatorik oder hier EU-weite Regeln, und dann folgt die internationale Koordinierung. Das wird erst mal zu einem Flickenteppich führen. Aber wir sehen jetzt schon eine Annäherung in der westlichen Welt, und bis zu einem gewissen Grad auch in China, wie das Risikomanagement von KI-Anbietern aussehen könnte. Das ist unter anderem inspiriert vom Frontier Model Forum, das Amazon, Anthropic, Google, Meta, Microsoft und Open AI gegründet haben. Es geht darum, die richtige Balance zu finden: Die Regeln müssen die Öffentlichkeit schützen, dürfen aber nicht zu komplex zu befolgen sein. Die Grundidee ist einfach und dieselbe wie in anderen Branchen, in denen gefährliche Dinge gebaut werden: Bevor etwas in den Umlauf kommt, müssen die Entwickler den zuständigen Behörden zeigen, dass das System keinen signifikanten Schaden anrichtet.

Wie soll sich das beweisen lassen?

Man startet mit der Identifizierung von Risiken, die vom System ausgehen könnten. Das System muss auf diese Risiken hin getestet werden, durch Benchmarks oder die Simulation von Angriffen oder missbräuchlicher Nutzung. Vorab müssen bestimmte Grenzen festgelegt werden, die beim jeweiligen Risiko nicht überschritten werden dürfen. Dann muss man nachweisen, wie man die Risiken mitigieren möchte – bis hin zur Entscheidung, das System nicht zu veröffentlichen.

Sie haben am Code of Conduct mitgeschrieben, einer Art Bedienungsanleitung zum AI Act der EU. Was halten Sie von den europäischen KI-Regeln?

Sie haben Schwächen, weil sie ursprünglich als Verbraucherschutzregeln konzipiert wurden und eher nach der Veröffentlichung ansetzen. Aber insgesamt sehe ich sie positiv.

Alles auf den AI Act zu schieben, ist eine Ausrede. Die wahren Gründe sind andere: ein Mangel an Ehrgeiz und Risikobereitschaft in Politik und Wirtschaft. Die Europäer haben die Größenordnung der wirtschaftlichen Bedrohung durch KI noch nicht realisiert. Es besteht die Gefahr, dass europäische Unternehmen wegen ihrer fehlenden KI-Fähigkeiten im Wettbewerb mit amerikanischen oder chinesischen Konkurrenten nicht mehr mithalten können. Die Profite durch KI werden dann in den USA versteuert. Erst wenn die Europäer die Bedrohung realisieren, wird sich wohl etwas ändern – so wie bei der Unterstützung der Ukraine oder den Investitionen in die Verteidigung.

In Teilen der deutschen Wirtschaft gibt es eine gewisse Resignation, was die Entwicklung großer KI-Modelle angeht. Mit den US-Hyperscalern zu konkurrieren, sei „völlig verrückt“, hat zum Beispiel SAP-Chef Christian Klein gesagt. Europa solle lieber die Anwendung Künstlicher Intelligenz fördern, für einzelne Branchen und spezielle Anwendungen. Hat er Recht?

Es wäre ein großer Fehler, wenn die Europäer sich nur auf amerikanische Topmodelle verlassen würden. Diese Abhängigkeit verleiht den Anbietern und der Regierung jenseits des Atlantiks große Macht. Was wäre denn, wenn die führenden KI-Anbieter nur noch zweitklassige Modelle nach Europa vermieten und ihre beste KI für sich behalten, um damit eigene KI-getriebene Unternehmen in bestimmten Branchen aufzubauen, die mit dem Rest der Welt konkurrieren? Aktuell bekommen KI-Anbieter nur einen recht kleinen Teil der Marge. Aber wenn Unternehmen komplett von ihnen abhängen, können sie beliebig an der Preisschraube drehen. Dann automatisieren europäische Unternehmen zwar, schicken ihre Gewinne aber in die USA. Oder die US-Regierung könnte digitale Exportkontrollen über die besten Modelle verhängen. Europa braucht seine eigenen Top-KI-Modelle. Dafür brauchen die Europäer aber auch den nötigen Ehrgeiz, solche Modelle zu entwickeln, und den sehe ich aktuell nicht wirklich.

Es gibt immerhin Mistral aus Frankreich.

Ja, aber es braucht mehr Anbieter.

Halten Sie es denn für realistisch, dass europäische Unternehmen in der Entwicklung großer KI-Modelle noch aufholen?

Ja. Es ist absolut möglich, auch jetzt noch neue Modelle auf dem neuesten Stand der Technik zu entwickeln. Wir müssen dieser defätistischen Einstellung etwas entgegensetzen. Ich würde mich freuen, wenn Europa Vorreiter würde in einer neuen Art, über KI zu denken. Und zwar eine Art, die mit unseren Werten vereinbar ist. Es gäbe einen großen Markt für eine wirklich vertrauenswürdige KI. Unternehmen wollen keine manipulative und intransparente KI. Ich halte dieses Thema aktuell von den Märkten für unterbewertet, aber genau da könnte Europas Chance liegen. Es wäre eine deutlich bessere Welt, wenn nicht nur die USA und China, sondern auch eine Koalition liberaler Demokratien einschließlich Europa entscheiden, was für eine Zukunft wir errichten. Europa hat eine Chance.